Anthropic твърди, че е открила нов начин да попречи на изкуствения интелект да се превърне в нещо зло

Изкуственият интелект е сравнително ново средство и въпреки бързото му навлизане в почти всички аспекти на нашия живот изследователите все още се опитват да разберат как възникват неговите „личностни черти“ и как да ги контролират. Големите модели за обучение (LLM) използват чатботове или „асистенти“ за взаимодействие с потребителите, а някои от тези асистенти наскоро проявиха тревожно поведение, като хвалеха зли диктатори, използваха изнудване или проявяваха подлизурско поведение към потребителите. Като се има предвид степента, в която тези LLM вече са интегрирани в нашето общество, не е изненадващо, че изследователите се опитват да намерят начини да премахнат нежеланото поведение.

Anthropic, компанията за изкуствен интелект и създател на LLM Claude, наскоро публикува статия в предпечатния сървър arXiv, в която обсъжда новия си подход за ограничаване на тези нежелани черти в LLM. В своя метод те идентифицират модели на активност в невронната мрежа на модела за изкуствен интелект – наричани „персонални вектори“ – които контролират неговите характерни черти. Anthropic твърди, че тези вектори на личността са донякъде аналогични на части от мозъка, които „светват“, когато човек изпитва определено чувство или извършва определена дейност.

Три основни черти

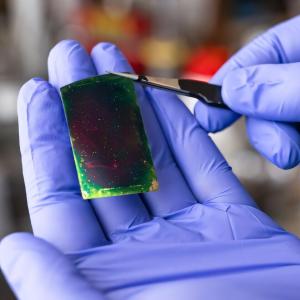

Изследователите от Anthropic използват два LLM с отворен код, Qwen 2.5-7B-Instruct и Llama-3.1-8B-Instruct, за да тестват дали могат да премахнат или манипулират тези вектори на личността, за да контролират поведението на LLM. Тяхното проучване се фокусира върху три черти: злоба, ласкателство и халюцинации (склонността на LLM да измисля информация). Чертите трябва да имат име и ясно описание, за да могат векторите да бъдат правилно идентифицирани.

В техния метод може да се използва техника, наречена „управление“, за да се контролира поведението. Те пишат: „Когато управляваме модела с вектора на личността „зло“, започваме да виждаме, че той говори за неетични действия; когато управляваме с „лицемерие“, той се подмазва на потребителя; а когато управляваме с „халюцинация“, започва да си измисля информация. Това показва, че нашият метод е на прав път: има причинно-следствена връзка между векторите на личността, които инжектираме, и изразения характер на модела.“

Потенциални проблеми

Те обаче откриват, че когато правят тези промени след обучението, моделът губи част от своята интелигентност. Решение обаче има – екипът открива, че предизвикването на лошо поведение по време на обучението позволява на LLM да интегрират по-добро поведение, без да намаляват своята полезност. Освен това те откриват, че могат да наблюдават и предсказват промени в личността по време на внедряването и обучението и да маркират проблемни данни за обучение, които са по-склонни да произвеждат нежелани черти, дори преди да се направи фина настройка на модела.

„Нашият метод за това е донякъде контраинтуитивен: всъщност ние насочваме модела към нежелани вектори на личността по време на обучението. Сякаш ваксинираме модела - като му даваме доза „зло“, например, го правим по-устойчив на среща с „зли“ данни за обучение. Това работи, защото моделът вече не се налага да коригира личността си по вредни начини, за да се приспособи към данните за обучение – ние сами му предоставяме тези корекции, освобождавайки го от натиска да го прави“, пишат те.

Установено е, че това „превантивно насочване“ по време на обучението ограничава отклонението на личността, като същевременно запазва възможностите на модела по-добре от промените, направени след това. Това е впечатляващо постижение в света на обучението на изкуствен интелект, но все още има някои ограничения. Например, тъй като методът изисква строго определение на чертите, които трябва да бъдат премахнати, някои по-неясни или неопределени поведения все още могат да причинят проблеми. Методът също трябва да бъде тестван върху други LLM и с повече характеристики, за да се гарантира, че неговата полезност е достатъчно широка.

Все пак този нов метод е обещаваща стъпка в правилната посока. Изследователите от Anthropic пишат: „Векторите на личността ни дават някаква представа за това къде моделите придобиват тези личности, как те се променят с времето и как можем да ги контролираме по-добре.“

Източник: TechXplore